管理与发布(针对网站所有者/运营者)

这是最常见的批量操作场景,旨在提高工作效率,减少重复性劳动。

批量上传/更新文章、产品、图片等

- 痛点:有成百上千的商品需要上架,或者需要将旧网站的文章迁移到新网站,一个一个手动操作非常耗时且容易出错。

- 解决方案:

- 后台自带批量导入功能:很多成熟的CMS(内容管理系统)或电商平台(如WordPress, Magento, Shopify)都内置了批量导入/导出功能,通常支持通过CSV、Excel或XML文件来批量创建或更新内容。

- 使用API:如果网站提供了RESTful API,这是最强大、最灵活的方式,你可以编写脚本(如Python)来读取本地数据,然后通过API接口将数据批量发送到服务器。

- 第三方集成工具:使用像Zapier、Make (原Integromat) 这样的自动化工具,可以将不同的应用连接起来,实现数据的批量同步和转换。

批量修改网站样式或配置

- 痛点:需要统一修改全站文章的字体、颜色,或者更新页脚的版权信息、联系方式等。

- 解决方案:

- 使用“查找并替换”工具:很多CMS的文本编辑器或数据库管理工具(如phpMyAdmin)支持全局查找并替换,在WordPress中,可以使用 "Better Search Replace" 这样的插件来批量替换数据库中的文本或URL。

- 批量编辑主题文件:如果你懂一些代码,可以通过FTP/SFTP连接到服务器,用代码编辑器(如VS Code)的“在文件中查找”功能,批量修改主题文件中的CSS或PHP代码。

- 使用浏览器开发者工具:对于一些简单的CSS样式修改,可以在浏览器开发者工具中修改并验证效果,然后找到对应的CSS文件进行批量替换。

数据采集与抓取(针对数据分析师、营销人员)

这个场景的目标是从网站上自动提取大量信息。

批量抓取产品信息、价格、评论等

- 痛点:需要监控竞争对手的产品价格变化,或者收集某个行业所有公司的联系方式,手动复制粘贴效率低下。

- 解决方案:

- 无代码/低代码工具(推荐入门):

- Octoparse: 可视化操作,通过点击页面元素来配置抓取规则,无需写代码,支持导出为CSV、Excel等格式。

- ParseHub: 类似Octoparse,也是通过拖拽和选择来配置抓取任务,非常直观。

- 编程方式(灵活强大):

- Python + Scrapy: Scrapy是一个强大的、用于爬取网站数据并提取结构化数据的爬虫框架,它适合构建大规模、复杂的爬虫项目。

- Python + BeautifulSoup/Requests: 对于中小型项目,使用

requests库发送HTTP请求获取网页HTML,再用BeautifulSoup库解析HTML,提取所需数据,是更轻量级的选择。

- 浏览器扩展:

- Web Scraper: 一个浏览器扩展,可以在页面上可视化地定义要抓取的数据,适合快速抓取单个网站的数据。

- 无代码/低代码工具(推荐入门):

批量下载文件(图片、PDF、视频等)

- 痛点:需要下载一个相册里的所有图片,或者某个专栏里的所有PDF报告。

- 解决方案:

- 专用下载工具:

- Internet Download Manager (IDM): 可以分析网页中的所有可下载链接,让你批量选择并下载。

- wget (命令行工具): 一个经典的命令行下载工具,可以通过正则表达式匹配URL来批量下载文件。

wget -r -A.jpg https://example.com/gallery/会递归下载gallery目录下所有.jpg文件。

- 编程方式:同样可以使用Python的

requests库结合os模块,遍历所有文件链接并逐一下保存到本地。

- 专用下载工具:

网站测试与自动化(针对开发人员/测试人员)

这个场景旨在提高软件质量和发布效率。

批量进行功能回归测试

- 痛点:每次网站更新后,都需要测试所有核心功能(如登录、注册、下单流程)是否正常,确保没有引入新的Bug。

- 解决方案:

- 自动化测试框架:

- Selenium: 用于Web应用程序的自动化测试,它可以模拟用户在浏览器上的各种操作(点击、输入、导航等),你可以编写测试脚本,让它自动执行所有测试用例。

- Cypress / Playwright: 现代化的前端测试工具,提供了更好的开发体验和更快的执行速度,非常适合持续集成/持续部署流程。

- 持续集成工具:将测试脚本集成到Jenkins, GitLab CI, GitHub Actions等CI/CD工具中,每次代码提交后自动运行测试,实现批量、自动化的回归测试。

- 自动化测试框架:

批量检查网站性能或SEO问题

- 痛点:需要检查网站成百上千个页面的加载速度,或者确认所有页面都设置了正确的

meta description和H1- 解决方案:

- SEO工具:使用Screaming Frog SEO Spider这样的专业工具,它可以像爬虫一样爬取你指定的所有页面,然后生成详细的报告,列出所有关于页面标题、描述、链接、头部信息等SEO问题的清单。

- 性能测试工具:使用Lighthouse(集成在Chrome开发者工具中)或GTmetrix,可以对单个页面进行性能分析,对于批量分析,可以编写脚本调用这些工具的API,或者使用WebPageTest等服务。

- 解决方案:

用户管理与营销(针对运营/市场人员)

批量发送邮件或消息

- 痛点:需要向大量用户发送活动通知、个性化营销邮件或站内信。

- 解决方案:

- 邮件营销服务:使用Mailchimp, SendGrid, Brevo (Sendinblue)等服务,它们提供了模板、用户分组、定时发送和效果追踪功能,并且严格遵守反垃圾邮件法规,确保邮件能成功送达。

- CRM系统:许多客户关系管理系统也内置了批量邮件或消息功能,可以将营销活动与用户管理深度结合。

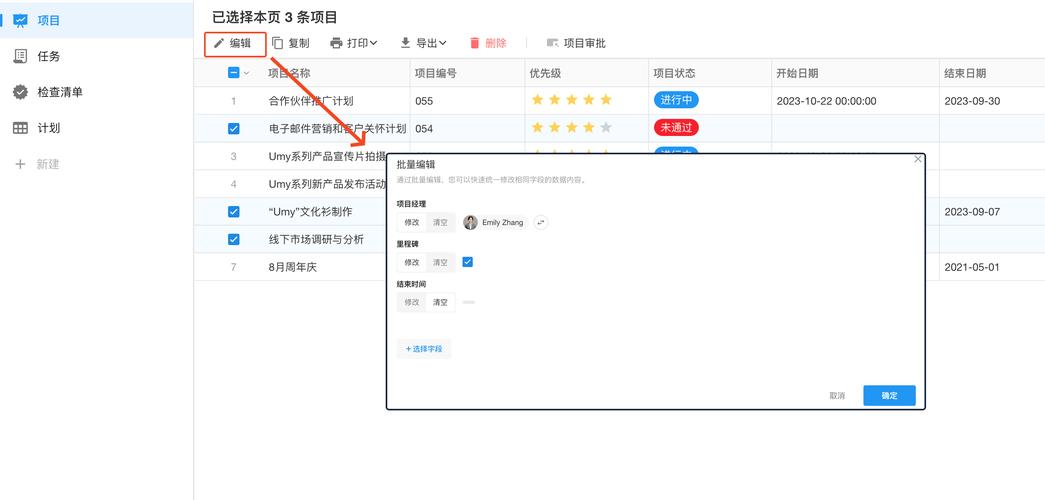

批量管理用户账户

- 痛点:需要为一批新员工批量创建账号,或者批量修改某个部门所有用户的角色。

- 解决方案:

- 用户管理系统后台:大多数企业级应用或网站后台都提供用户导入/导出功能,支持通过CSV文件进行批量增删改查。

- 企业身份提供商:使用Okta, Azure AD等工具,可以与公司的人力资源系统(如Workday)集成,实现员工入职、离职时账号的自动创建和禁用,这是最高效的批量管理方式。

⚠️ 重要注意事项与法律合规

在进行任何批量操作时,请务必遵守以下原则:

- 遵守

robots.txt协议:这是网站所有者告知爬虫哪些页面可以抓取、哪些不可以的规则,在抓取数据前,请务必先查看目标网站的robots.txt文件(https://example.com/robots.txt),尊重其意愿。 - 查看《服务条款》:很多网站的服务条款中明确禁止自动化访问或数据抓取,违反条款可能会导致你的IP被封禁,甚至面临法律诉讼。

- 不要过度请求:批量操作(尤其是爬取)会给目标服务器带来巨大压力,设置合理的请求间隔(每次请求间隔1-5秒),避免对网站服务造成影响,这是一种网络礼仪。

- 数据使用合法合规:抓取到的数据,特别是个人信息,必须遵守《网络安全法》、《个人信息保护法》等相关法律法规,不得用于非法用途。

- 版权问题:抓取到的内容(如文章、图片、视频)可能受版权保护,请确保你的使用方式是合法的。

| 场景 | 目标 | 常用工具/方法 | | :--- | :--- | :--- |管理 | 批量上传/修改文章、产品 | CMS后台导入、API、Zapier | | 数据采集 | 抓取产品信息、价格、文件 | Octoparse, Python(Scrapy/Requests), wget | | 网站测试 | 自动化回归测试、性能/SEO检查 | Selenium, Cypress, Screaming Frog, Lighthouse | | 用户营销** | 批量发邮件、管理用户 | Mailchimp, CRM系统, 企业IDP |

希望这个详细的分解能帮助您更好地理解和实现网站批量操作,如果您有更具体的需求,可以提供更多细节,我可以给出更有针对性的建议。