高性能Web服务器是现代互联网架构的核心组件,其性能直接影响用户体验、业务承载能力和系统稳定性,本文将从技术原理、关键优化方向及运维实践三个维度,详细解析高性能Web服务器的构建与管理。

高性能Web服务器的核心架构

高性能Web服务器的实现依赖于多层次的架构设计,在硬件层面,CPU、内存、存储和网络I/O是基础瓶颈,采用多核处理器(如Intel Xeon、AMD EPYC)结合大容量内存(64GB以上)和NVMe SSD存储,可显著提升数据处理能力,网络方面,万兆以太网或RDMA(远程直接内存访问)技术能减少网络延迟,尤其适用于高并发场景。

软件架构上,主流Web服务器如Nginx、Apache HTTPD、Tomcat等通过模块化设计和事件驱动模型实现高性能,以Nginx为例,其采用异步非阻塞I/O模型(epoll/kqueue),单进程可处理数万并发连接,远超Apache的prefork模式(每个连接一个进程),下表对比了常见Web服务器的核心特性:

| 服务器类型 | 模型 | 并发处理能力 | 适用场景 |

|---|---|---|---|

| Nginx | 异步非阻塞 | 10万+ | 静态资源、反向代理 |

| Apache | 进程/线程池 | 1千-1万 | 、模块化扩展 |

| Tomcat | 线程池 | 1千-5千 | Java应用、Servlet容器 |

| Caddy | 事件驱动 | 5万+ | HTTPS自动化、简化配置 |

性能优化的关键技术

多级缓存策略

缓存是提升性能最直接的手段,浏览器缓存(通过HTTP头如Cache-Control、Expires)减少重复请求;CDN缓存(如Cloudflare、阿里云CDN)将静态资源分发至边缘节点,降低源站压力;服务器本地缓存(如Redis、Memcached)缓存热点数据,减少数据库访问,Nginx可通过proxy_cache模块配置反向代理缓存,对动态页面进行缓存,大幅降低后端负载。

负载均衡与集群扩展

当单机性能不足时,需通过负载均衡横向扩展,硬件负载均衡器(如F5、A10)性能强大但成本高,软件方案如Nginx、HAProxy(基于L4/L7层调度)更具性价比,负载算法需结合业务场景:轮询(默认)适合服务器性能均等的情况,最少连接数(least_conn)能动态分配负载,IP哈希(ip_hash)可保持会话粘性,会话共享(如Redis存储Session)是集群扩展的必要条件,避免用户因请求分发到不同节点而丢失会话。

代码与协议优化

后端代码需减少锁竞争、优化数据库查询(如索引、分页),并采用异步编程(如Node.js、Go协程)提升吞吐量,协议层面,HTTP/2通过多路复用、头部压缩减少延迟,HTTPS(TLS 1.3)通过会话复用降低握手开销,Nginx可通过http2模块启用HTTP/2,配合gzip或brotli压缩进一步减少传输数据量。

运维实践与监控

高性能服务器的运维需关注稳定性、安全性和可观测性。

- 配置管理:使用Ansible、Terraform实现自动化部署,避免手动配置错误,Nginx配置需优化

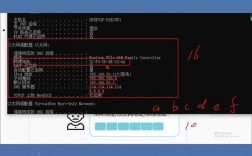

worker_processes(通常设为CPU核心数)、worker_connections(单进程最大连接数)等参数。 - 监控体系:通过Prometheus+Grafana监控服务器指标(CPU、内存、磁盘I/O、网络带宽),以及应用指标(QPS、响应时间、错误率),日志分析工具(如ELK Stack)需记录访问日志(

access.log)和错误日志(error.log),便于定位问题。 - 容灾与弹性伸缩:通过Keepalived实现VIP(虚拟IP)高可用,避免单点故障;结合Kubernetes或云厂商(如AWS Auto Scaling)实现基于负载的自动扩缩容,应对流量高峰。

- 安全加固:定期更新服务器软件版本,启用WAF(Web应用防火墙)防御SQL注入、XSS等攻击,配置SSL证书(如Let's Encrypt)并启用HSTS(HTTP严格传输安全)。

相关问答FAQs

Q1: 如何判断Web服务器是否需要升级配置?

A1: 需通过监控数据综合判断,若CPU持续高于80%、内存使用率超过90%、磁盘I/O等待时间超过50ms,或响应时间(如p99值)显著增加,且排除代码和配置问题后,说明硬件资源已不足,此时可考虑升级CPU/内存、增加SSD或通过负载均衡扩展集群。

Q2: 高并发场景下,Nginx突然出现502错误,如何快速排查?

A2: 502错误通常意味着后端服务不可用或超时,排查步骤如下:

- 检查后端服务进程(如Tomcat、PHP-FPM)是否存活,查看

error.log确认是否有崩溃或异常; - 检查Nginx配置中的

proxy_connect_timeout、proxy_read_timeout是否过小(默认60s),可适当调大; - 查看服务器资源(CPU、内存)是否耗尽,导致后端进程无法响应;

- 检查网络连通性,如防火墙规则或负载均衡器健康检查是否正常。

通过nginx -t验证配置语法,并用curl -I模拟请求测试后端服务可用性。